Yerel quay veya registry sunucularımızdaki ee leri ansible ile kullanabiliyoruz.

Bunun için kendi yaptığımız ee leri veya hazır ee leri yükleyerek kullanabiliriz.

İşlemler:

[rh294@bastion ~]$ podman tag registry.redhat.io/ansible-automation-platform-25/ee-supported-rhel9:1.0.0-1033 bastion.local.lab/ansible-automation-platform-25/ee-supported-rhel9:1.0.0-1033

[rh294@bastion ~]$ podman images

REPOSITORY TAG IMAGE ID CREATED SIZE

registry.redhat.io/ansible-automation-platform-25/ee-supported-rhel8 latest 48ced021b0e1 13 days ago 2.28 GB

bastion.local.lab/library/ee-supported-rhel8 1.0.0-1032 48ced021b0e1 13 days ago 2.28 GB

registry.redhat.io/ansible-automation-platform-25/ee-supported-rhel8 1.0.0-1032 48ced021b0e1 13 days ago 2.28 GB

bastion.local.lab/ansible-automation-platform-25/ee-supported-rhel9 1.0.0-1033 15f3a7cd419c 13 days ago 2.27 GB

registry.redhat.io/ansible-automation-platform-25/ee-supported-rhel9 1.0.0-1033 15f3a7cd419c 13 days ago 2.27 GB

registry.redhat.io/ansible-automation-platform-25/ee-supported-rhel9 latest 15f3a7cd419c 13 days ago 2.27 GB

bastion.local.lab/library/ee-supported-rhel9 1.0.0-1033 15f3a7cd419c 13 days ago 2.27 GB

quay.io/ansible/ansible-runner latest bec0dc171168 3 years ago 816 MB

[rh294@bastion ~]$

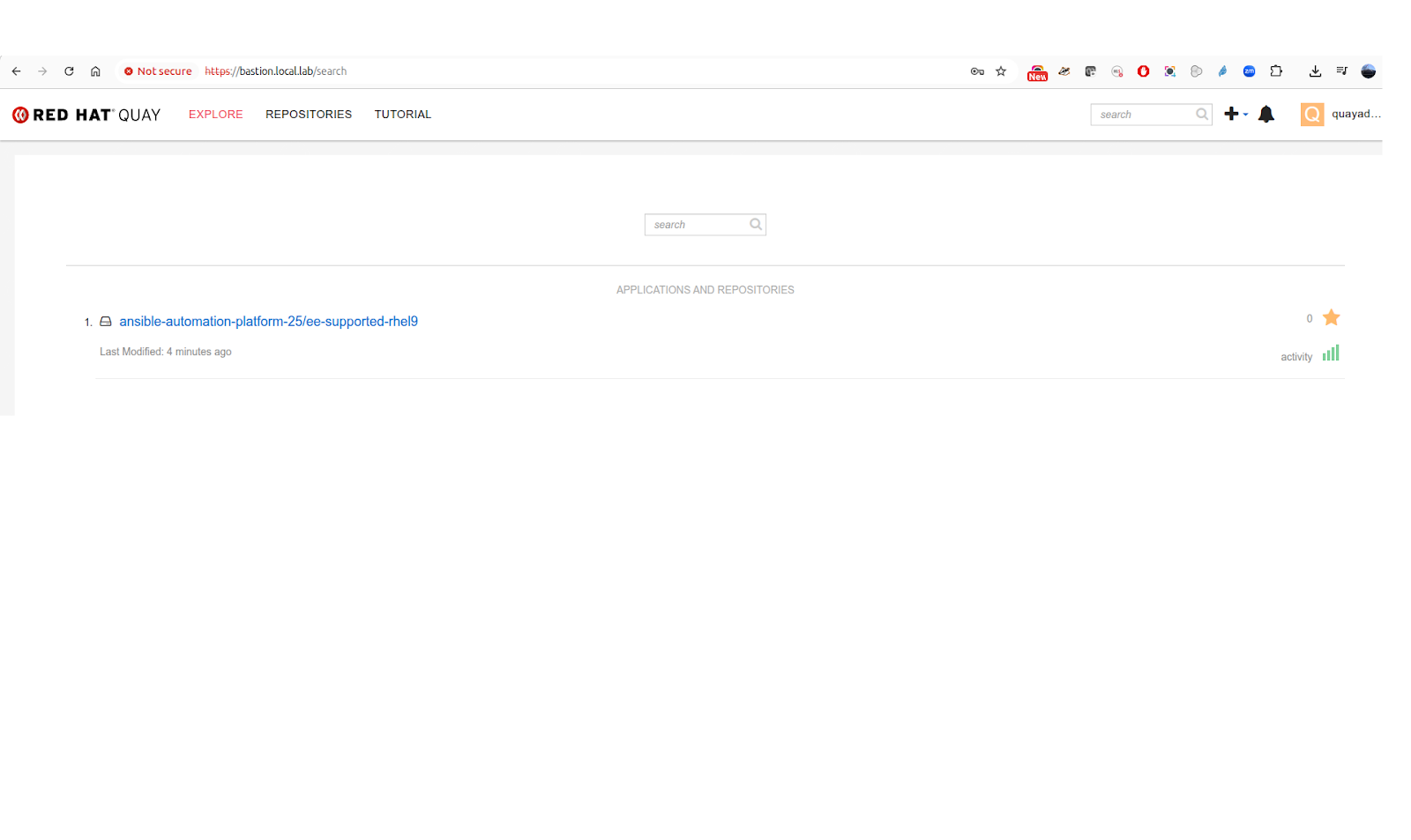

[rh294@bastion ~]$ podman push bastion.local.lab/ansible-automation-platform-25/ee-supported-rhel9:1.0.0-1033 --remove-signatures

Copying blob 8361195c374b done |

Copying blob b492ce482b81 done |

Copying blob a080cada37e9 skipped: already exists

Copying blob 80a3047bb0cc done |

Copying config 15f3a7cd41 done |

Writing manifest to image destination

[rh294@bastion ~]$